DOI: 10.11817/j.issn.1672-7207.2019.09.013

RGB-D与MeanShift相结合的实时目标跟踪

王广龙,田杰,朱文杰,方丹

(陆军工程大学石家庄校区 纳米技术与微系统实验室,河北 石家庄,050003)

摘 要:

hift跟踪算法目标易受到周围相似背景区域干扰的问题,引入图像的RGB-D特征,研究并实现结合RGB-D与MeanShift的实时目标跟踪算法。首先,提出一种新颖的相似性度量方法优化二次型距离(advanced quadratic-form distance,AQFD);其次,基于颜色和深度特征完善了特征权重在线自适应调整机制和目标模型更新策略;最后,对该算法进行仿真分析并基于Jetson TX2平台实现。研究结果表明:本文算法在目标受到周围相似背景区域干扰情况下仍能够完成目标跟踪任务,优于先进算法Staple,具有良好的准确性与鲁棒性,并且能够应用于实时跟踪。

关键词:目标跟踪;MeanShift;RGB-D;实时跟踪

中图分类号:TP391.4 文献标志码:A 文章编号:1672-7207(2019)09-2163-08

Real-time object tracking combined RGB-D with MeanShift

WANG Guanglong, TIAN Jie, ZHU Wenjie, FANG Dan

(Laboratory of Nanotechnology and Microsystems, Shijiazhuang Campus of Army Engineering University, Shijiazhuang 050003, China)

Abstract: Arm to solve the problem that the object is susceptible to interference from similar surrounding background in MeanShift, RGB-D feature was introduced, and thus a real-time object tracking combined RGB-D with MeanShift was proposed. Firstly, a novel similarity measurement method, advanced quadratic-form distance (AQFD),was put forward. Secondly, the online self-adaptive adjustment mechanism of feature weights and updating strategy of object model were improved. Finally, the method was simulated based on Matlab and implemented on Jetson TX2. The results show that the proposed method which is better than Staple performs well in accuracy and robustness in the case that the object is disturbed by similar surrounding background, and it can be applied to real-time tracking applications.

Key words: object tracking; MeanShift; RGB-D; real-time tracking

目标跟踪是计算机视觉领域的重要研究方向,通常基于单目摄像头实现行人、车辆、障碍物以及标志物等目标信息的采集,给出目标在初始帧中的位置和大小,进而估计出目标在后续帧图像中的状态。但是,单目摄像头采集的目标特征信息有限,相比较而言,双目摄像头可以更加全面地反映目标特征信息,获取精确的深度特征。目标跟踪按照有无检测过程的参与一般可以划分为判别式跟踪与生成式跟踪[1]。判别式跟踪主要包括两大类:基于相关滤波和深度学习的跟踪算法。HENRIQUES等[2-8]在相关滤波研究方面做出了重要贡献,提出了CSK,KCF/DCF,Staple,CN,DSST,C-COT[7]和ECO[8]等算法,分别从特征表达、尺度更新、降低边界效应、模型更新策略、精简训练集等角度进行优化。基于深度学习的跟踪算法性能优异,学者们从不同角度解决训练数据缺失的问题[9-10]。判别式跟踪算法考虑了背景信息,一般情况下鲁棒性更强,但其对训练样本的依赖程度较高,受训练样本影响极大。MeanShift属于生成式跟踪算法,其调节参数少、鲁棒性强、速度快,是当前目标跟踪领域的重要研究方向之一[11],VOT 2015官方推荐的实时算法就包括基于MeanShift框架的ASMS(scale-adaptive mean-shift)[12],平均帧率达125 帧/s。然而,MeanShift只考虑了目标的颜色直方图特征,当目标与背景颜色相近时,易受这些相似区域的干扰。张铁等[13-14]通过结合粒子滤波的方法提高了算法的分辨力,但粒子滤波一定程度上影响了算法的实时性。近年来,RGB-D传感器越来越多地应用于3D人机交互界面应用中,已能够实现手势识别等功能[15],2015年美国Stereolab公司推出3D摄像机ZED,可用于实时获取深度特征。在此基础上,本文作者基于双目立体像机ZED引入图像RGB-D特征,在MeanShift框架基础上提出了基于RGB-D的实时跟踪算法。首先,提出优化二次型距离的相似性度量方法代替Bhattacharyya系数,提高了度量的合理性与准确性;其次,基于颜色和深度特征,完善了权重在线自适应调整机制和目标模型更新策略;最后,通过仿真和实验分析的方法验证算法的有效性。

1 基于RGB-D与MeanShift的实时跟踪算法基本思想

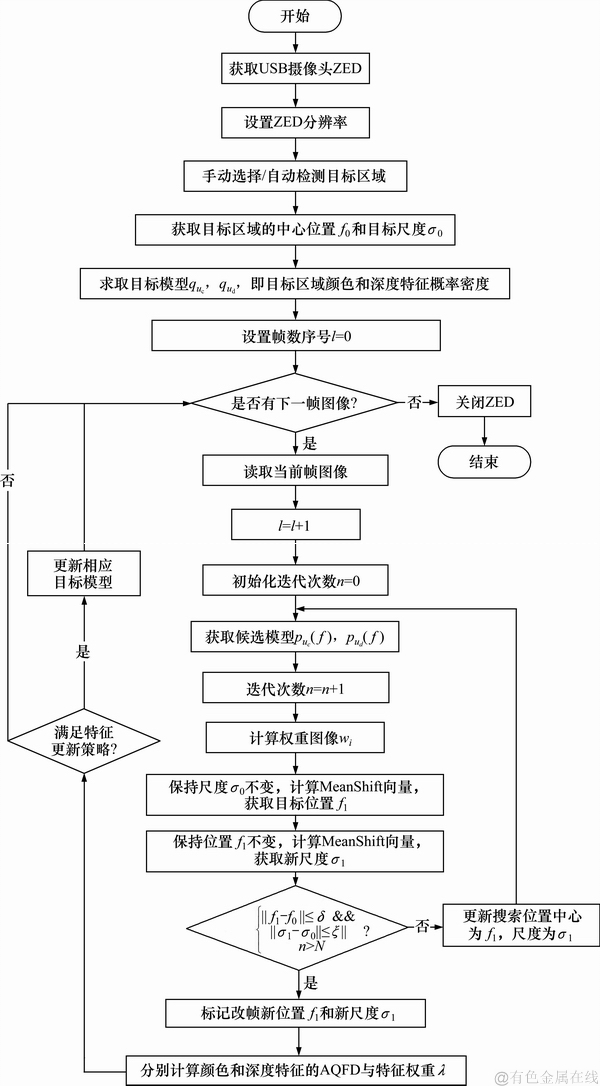

MeanShift是一种常用的目标跟踪算法,针对算法中目标易受到周围相似区域干扰的问题,本文引入RGB-D特征,将深度特征与颜色特征相融合,借鉴颜色直方图的模式,基于深度图构建深度特征直方图。实验中发现,跟踪过程中存在目标丢失现象,进一步观察发现:当目标发生微小位移时,Bhattacharyya系数产生急剧变化,某次调试过程中前一帧相似值高达0.898 6,而下一帧迭代时突降到0.588 3,这是由于Bhattacharyya系数假设直方图各个子空间是正交而导致的。该假设条件不适用于深度特征直方图,因此,本文提出了一种新颖的相似性度量方法优化二次型距离(advanced quadratic-form distance,AQFD),充分考虑了不同子空间之间的相关性和可分辨性。基于颜色特征和深度特征,提出了一种在线特征权重自适应调整机制。利用不同特征间的互补性,针对匹配度低及可信度差的特征进行更新,每一帧最多只选择1种特征,兼顾目标模型的适应性与稳健性,进一步完善了目标模型更新策略。

提出的优化算法流程如图1所示。

假设第t帧跟踪结果为

Step 1 基于

Step 2 计算权重图像

Step 3 保持尺度

Step 4 保持

Step 5 将步骤4得到的结果代替步骤1中的输入参数,重复步骤1~4直到空间维和尺度维均收敛或达到指定迭代次数;

Step 6 满足更新策略的进行目标模型的更新。

图1 优化算法流程图

Fig. 1 Flow chart of advanced algorithm

2 RGB-D与MeanShift相结合的跟踪算法

2.1 基于优化二次型距离的相似性度量方法

由于传统的相似性度量方法Bhattacharyya系数的前提条件是假设直方图各子空间是正交的,而深度直方图不满足该假设条件,因此,本文提出了一种新的相似性度量方法。二次型距离(quadratic-form distance,QFD)充分考虑了不同子空间之间的相关性,它通过Mahalanobis距离演化生成,定义为

式中,

虽然QFD考虑了子空间之间的相关性,但各子空间相关性区分度低,为此,将余弦距离与QFD相结合,旨在提高各子空间的可分辨性。余弦距离公式为

式(4)默认直方图各子空间相互独立,结合式(3),将式(4)优化为

令

称为优化二次型距离。由式(2)可知,拥有

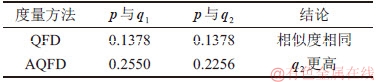

优化二次型距离既考虑了不同子空间之间的相关性,同时也兼顾了子空间之间的可分辨性。举例说明:令

表1 QFD和AQFD相似性度量结果对比

Table 1 Measurement results of QFD and AQFD

2.2 基于颜色和深度特征的在线权重自适应调整机制与目标模型更新策略

基于多特征的MeanShift常采用联合直方图方法[17],将深度作为新特征,但联合直方图一般具有较高维数,目标特征分布稀疏,易受到光照、运动图像模糊等因素干扰。分别基于颜色和深度直方图建立目标模型,并在线自适应调整特征权重,以适应目标的实时变化。

令

式中:

为适应目标与周围环境的实时变化,采用在线特征权重自适应调整机制,自适应调整参数

由式(10)可知,

式中:

令

式(12)表明特征权重只与参数

实际应用过程中,由于外部(光照、视角等)变化和自身(形变、姿态等)因素的影响,目标模型存在渐变的过程,因此,建立合理的目标模型更新策略[18]是长时间有效跟踪目标的必要条件。合理的目标模型更新策略即在目标的适应性与稳健性之间寻找平衡,经典更新策略如下:

式中,

对于多特征模型,可利用特征之间的互补性解决模型漂移问题。当

本文采用的目标模型更新策略主要针对匹配度低及可信度差的特征,这样既可以避免错误的更新造成整个目标模型的漂移,又可以使得目标模型对环境具有一定的适应性。分别为优化二次型距离与特征权重设置阈值

当且仅当满足式(14)的阈值条件时,才更新该特征模型,否则保持不变。每一帧最多只选择一种特征更新,以避免整个目标模型漂移。

3 实验及结果分析

2015年美国Stereolab公司推出的3D摄像机ZED是国际上首款能够应用于室外环境、实现大量程深度检测的摄像机。ZED量程为0.5~20.0 m,长×宽×高为175 mm×30 mm×30 mm,基线为120 mm,支持多帧率、多分辨率工作模式,支持Linux,Windows,Mac操作系统,支持ARM架构与X86架构处理器。

3.1 相似背景区域干扰实验

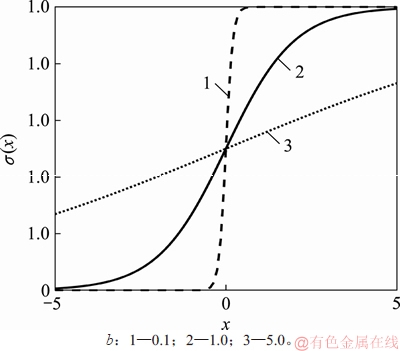

图2

Fig. 2 Function

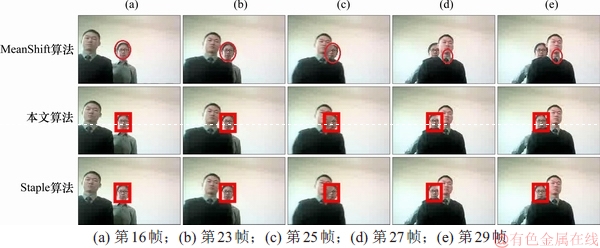

本文提出的跟踪算法需要利用目标的深度特征,而现有公开测评集多是基于2D图像序列,无法提供深度信息。因此,本文基于ZED摄像机采集了测评集,并标定了每帧图像中目标位置的真值,便于进行不同算法间性能的定量对比。在i5-7300HQ处理器、8GB内存、Matlab R2017b条件下,分别采用文献[19]中的经典MeanShift算法、本文算法和Staple算法[4]处理测评集A,分别抽取了第16帧、23帧、25帧、27帧和29帧图像便于观察,各算法跟踪效果如图3所示。

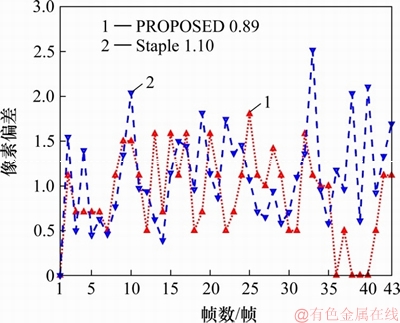

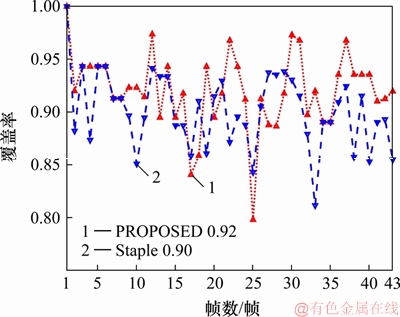

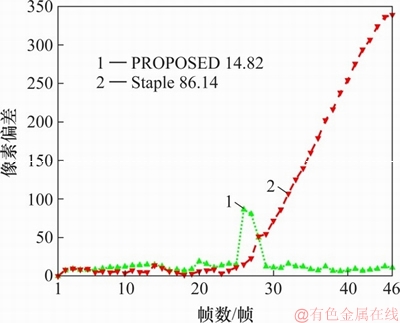

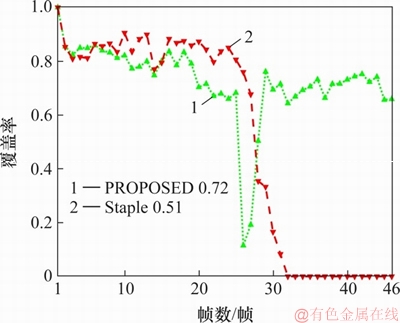

由图3可知:MeanShift算法在目标被遮挡前跟踪效果良好,当目标被相似背景遮挡后,跟踪任务失败,而本文算法虽然也是基于MeanShift框架的,但是引入深度特征后,可以很好地区分开目标与颜色相近的背景区域,提高算法的辨别力与可靠性,完成目标跟踪任务。定性来看,本文算法和Staple均较好地完成了相似背景区域干扰实验,对比每帧图像的跟踪结果与真值之间的距离,获得每帧图像的像素偏差,如图4所示,计算每帧图像的覆盖率,即

图3 MeanShift算法、本文算法和Staple在测评集A中的跟踪结果

Fig. 3 Results of MeanShift, proposed method and Staple in benchmark A

图4 本文算法和Staple算法在测评集A中的像素偏差

Fig. 4 Pixel error of proposed method and Staple in benchmark A

图5 本文算法和Staple算法在测评集A中的覆盖率

Fig. 5 Overlap rate of proposed method and Staple in benchmark A

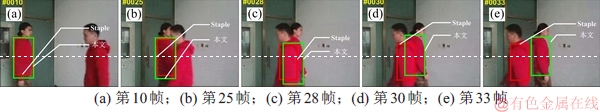

为进一步实验本文算法的跟踪效果,采用一个跟踪难度系数更高的测评集B,并与在上一测评集中表现良好的Staple算法进行对比,分别抽取了第10帧、25帧、28帧、30帧和33帧图像便于观察,跟踪效果如图6所示,像素偏差和覆盖率分别如图7和图8所示。实验结果表明:本文算法在受到相似背景干扰情况下,仍能够实现目标的稳定、可靠跟踪,展现了较强的鲁棒性,而Staple算法跟踪失败,本文算法和Staple算法的平均像素偏差分别为14.82和86.14,平均覆盖率分别为0.72和0.51。

图6 本文算法和Staple算法在测评集B中的跟踪结果

Fig. 6 Results of proposed method and Staple in benchmark B

图7 本文算法和Staple算法在测评集B中的像素偏差

Fig. 7 Pixel error of proposed method and Staple in benchmark B

3.2 实验平台与算法实现

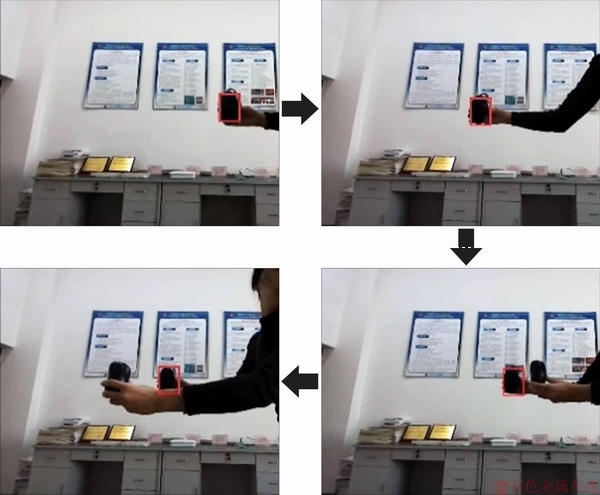

系统硬件平台主要由嵌入式人工智能超级计算平台Jetson TX2和3D摄像机ZED组成,本地主机采用i5-4590 CPU、4GB内存和Ubuntu14.04 64-bit操作系统,ZED分辨率设置为2 560×720。本文算法可实现对任意选定目标的跟踪,本实验中,选择鼠标作为最初跟踪目标,过程中利用另一个鼠标去遮挡原始目标,跟踪效果如图9所示。

图8 本文算法和Staple算法在测评集B中的覆盖率

Fig. 8 Overlap rate of proposed method and Staple in benchmark B

图9 实时跟踪效果图

Fig. 9 Real-time tracking results

实验结果表明:本文算法可实现任意选定目标的跟踪,同时在具有相近颜色特征的背景区域干扰下,仍顺利地完成目标跟踪任务,展现了较强的鲁棒性。在分辨率为2 560×720的条件下,平均处理速度约为30 帧/s,大于制式要求的24 帧/s,满足系统实时性要求。

4 结论

1) 基于双目立体像机ZED引入RGB-D特征,在MeanShift框架基础上提出了基于RGB-D的实时跟踪算法。该算法是基于优化二次型距离的相似性度量方法,实现了特征权重在线自适应调整并完善了目标模型的更新策略。

2) 当目标被周围相似背景区域干扰时,本文算法仍能够完成目标跟踪任务,平均像素偏差和覆盖率分别为0.89和0.92,优于Staple算法。

3) 本文算法在难度系数更高的测评集中仍能够稳定、可靠地完成目标跟踪任务,平均像素偏差和覆盖率分别为14.82和0.72,优于Staple算法。

4) 本文算法基于Jetson TX2平台的处理速度达30帧/s,满足系统实时性要求。

参考文献:

[1] 尹宏鹏, 陈波, 柴毅, 等. 基于视觉的目标检测与跟踪综述[J]. 自动化学报, 2016, 42(10): 1466-1489.

YIN Hongpeng, CHEN Bo, CHAI Yi, et al. Vision-based object detection and tracking: a review[J]. Acta Automatica Sinica, 2016, 42(10): 1466-1489.

[2] HENRIQUES J F, CASEIRO R, MARTINS P, et al. Exploiting the circulant structure of tracking-by-detection with kernels[M]// European Conference on Computer Vision. Berlin, Heidelberg: Springer, 2012: 702-715.

[3] HENRIQUES J F, CASEIRO R, MARTINS P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583-596.

[4] BERTINETTO L, VALMADRE J, GOLODETZ S, et al. Staple: complementary learners for real-time tracking[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. New York, USA: IEEE, 2016:1401-1409.

[5] DANELLJAN M, KHAN F S, FELSBERG M, et al. Adaptive color attributes for real-time visual tracking[C]//Proceedings of the 2014 IEEE Conference on Computer Vision and Pattern Recognition. Columbus, USA: IEEE, 2014: 1090-1097.

[6] DANELLJAN M, H GER G, KHAN F S, et al. Discriminative scale space tracking[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(8): 1561-1575.

GER G, KHAN F S, et al. Discriminative scale space tracking[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(8): 1561-1575.

[7] DANELLJAN M, ROBINSON A, KHAN F S, et al. Beyond correlation filters: learning continuous convolution operators for visual tracking[C]//European Conference on Computer Vision. Cham: Springer, 2016: 472-488.

[8] DANELLJAN M, BHAT G, KHAN F S, et al. ECO: efficient convolution operators for tracking[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition.New York, USA: IEEE, 2017: 6931-6939.

[9] WANG N Y, YEUNG D Y. Learning a deep compact image representation for visual tracking[C]//Proceedings of the 26th International Conference on Neural Information Processing Systems. Lake Tahoe, USA, 2013: 809-817.

[10] NAM H, HAN B. Learning Multi-domain convolutional neural networks for visual tracking[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. New York, USA: IEEE, 2015:4293-4302.

[11] 顾幸方, 茅耀斌, 李秋洁. 基于Mean Shift的视觉目标跟踪算法综述[J]. 计算机科学, 2012, 39(12): 16-24.

GU Xingfang, MAO Yaobin, LI Qiujie. Survey on visual tracking algorithms based on mean shift[J]. Computer Science, 2012, 39(12): 16-24.

[12] VOJIR T, NOSKOVA J, MATAS J. Robust scale-adaptive mean-shift for tracking[J]. Pattern Recognition Letters, 2014, 49: 250-258.

[13] 张铁, 马琼雄. 人机交互中的人体目标跟踪算法[J]. 上海交通大学学报, 2015, 49(8): 1213-1219, 1230.

ZHANG Tie, MA Qiongxiong. Human object tracking algorithm for human-robot interaction[J]. Journal of Shanghai Jiao Tong University, 2015, 49(8): 1213-1219, 1230.

[14] 张铁, 马琼雄. 基于局部背景特征点的目标定位和跟踪[J]. 中南大学学报(自然科学版), 2016, 47(9): 3040-3049.

ZHANG Tie, MA Qiongxiong. Target location and tracking based on local background feature points[J]. Journal of Central South University(Science and Technology), 2016, 47(9): 3040-3049.

[15] 姚远, 张林剑, 乔文豹. RGB-D图像中手部样本标记与手势识别[J]. 计算机辅助设计与图形学学报, 2013, 25(12): 1810-1817.

YAO Yuan, ZHANG Linjian, QIAO Wenbao. Hand part labeling and gesture recognition from RGB-D data[J]. Journal of Computer-Aided Design & Computer Graphics, 2013, 25(12): 1810-1817.

[16] COLLINE R T. Mean-shift Blob tracking through scale space[C]// IEEE Computer Vision & Pattern Recognition, Madison, USA: IEEE, 2003: 234-240.

[17] NING Jifeng, ZHANG Lei, ZHANG D, et al. Robust object tracking using joint color-texture histogram[J]. International Journal of Pattern Recognition and Artificial Intelligence, 2009, 23(7): 1245-1263.

[18] COMANICIU D, MEER P. Mean shift: a robust approach toward feature space analysis[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24(5): 603-619.

[19] COMANCIU D, RAMESH V, MEER P. Real-time tracking of non-rigid objects using mean shift[C]//The IEEE Conference on Computer Vision and Pattern Recognition. Washington, USA: IEEE, 2000: 142-149.

(编辑 赵俊)

收稿日期: 2018-10-30; 修回日期: 2019 - 0 2-24

基金项目(Foundation item):国防预研基金资助项目(51327030104)(Project(51327030104) supported by the National Defense Pre-Research Foundation of China)

通信作者:王广龙,博士,教授,从事计算机视觉、人工智能、图像处理研究;E-mail:ysdmhj@163.com

摘要:针对MeanShift跟踪算法目标易受到周围相似背景区域干扰的问题,引入图像的RGB-D特征,研究并实现结合RGB-D与MeanShift的实时目标跟踪算法。首先,提出一种新颖的相似性度量方法优化二次型距离(advanced quadratic-form distance,AQFD);其次,基于颜色和深度特征完善了特征权重在线自适应调整机制和目标模型更新策略;最后,对该算法进行仿真分析并基于Jetson TX2平台实现。研究结果表明:本文算法在目标受到周围相似背景区域干扰情况下仍能够完成目标跟踪任务,优于先进算法Staple,具有良好的准确性与鲁棒性,并且能够应用于实时跟踪。

[1] 尹宏鹏, 陈波, 柴毅, 等. 基于视觉的目标检测与跟踪综述[J]. 自动化学报, 2016, 42(10): 1466-1489.

[11] 顾幸方, 茅耀斌, 李秋洁. 基于Mean Shift的视觉目标跟踪算法综述[J]. 计算机科学, 2012, 39(12): 16-24.

[13] 张铁, 马琼雄. 人机交互中的人体目标跟踪算法[J]. 上海交通大学学报, 2015, 49(8): 1213-1219, 1230.

[14] 张铁, 马琼雄. 基于局部背景特征点的目标定位和跟踪[J]. 中南大学学报(自然科学版), 2016, 47(9): 3040-3049.

[15] 姚远, 张林剑, 乔文豹. RGB-D图像中手部样本标记与手势识别[J]. 计算机辅助设计与图形学学报, 2013, 25(12): 1810-1817.