基于高斯混合模型的情感LPC系数的研究

陈明义,许玲玲,陈宁

(中南大学 信息科学与工程学院,湖南 长沙,410083)

摘 要:

音情感特征的发声模型研究的具体现状,通过探索情感特征与线性预测编码(LPC)系数之间的映射关系,提出建立LPC系数情感模型的新方法。该方法在中科院情感语音库的基础上分别建立高兴、愤怒、悲伤及中性4种情感数据库;通过采用不同情感语音的LPC特征矢量,结合动态时间规整技术(DTW)、期望最大化算法(EM)和最小均方误差准则(MMSE)对高斯混合模型进行训练和参数估计,最终获得高兴、愤怒、悲伤这3种情感对中性语音的LPC系数映射规则函数,完成对情感LPC系数的建模。研究结果表明:建立的情感模型有效表征了不同情感对LPC系数的影响;该方法为情感语音合成、识别等研究提供了新思路。

关键词:

中图分类号:TP391 文献标志码:A 文章编号:1672-7207(2013)09-3701-06

Research on emotional LPC parameter based on GMM

CHEN Mingyi, XU Lingling, CHEN Ning

(School of Information Science and Engineering, Central South University, Changsha 410083, China)

Abstract: Considering the inadequacy of the study on emotional speech modeling, a new method of emotional speech modeling of linear predictive coding (LPC) parameter was presented. The method established four kinds of emotional speech database including happy, angry, sad and neutral emotion recorded by Chinese Academy of Sciences. Different emotional LPC feature vectors were used combined with the dynamic time warping technology, expectation maximization (EM) algorithm and minimum mean square error (MMSE) criterion. Finally LPC parameter mapping rule function of three kinds of emotional speech to neutral speech was gotten. The emotional LPC parameter modeling was completed. The results show that the emotional speech model can efficiently characterize the different emotional effects on LPC parameter. The new method provides a new idea to the research of the influence for emotional speech synthesis and recognition.

Key words: emotional speech modeling; LPC parameter; Gaussian mixture model (GMM); EM algorithm

情感信息作为语音信号的重要组成部分,是人机通信技术智能化的重要标志之一。现阶段对于情感语音的研究在国内外都还处于一个起步阶段,由于情感给语音带来的变化对语音合成、语音识别、说话人识别的影响较大,语音的情感研究逐渐引起人们的重视[1]。在语音处理和人工智能等领域,对情感信息的研究有着十分重要的意义。心理学和韵律学研究结果表明,说话者的情感在语音中最直观的表现就是韵律特征和语音质量特征的变化[2-3],因此,对语音情感的研究也是普遍从韵律特征和音质特征开始。音质特征作为情感表达的一个非常重要的方面,利用音质特征进行语音情感研究是近年来众多学者的研究思路之一[4]。LPC系数即线性预测系数,它作为基本的音质类参数,是对声管模型的一种描述。情感变化必将引起声管的形变,这将导致LPC系数随情感发生变化[5-6],但它在各种情感语音下的表现规律还不清楚。情感建模既是情感心理学研究者追求的目标,也是情感计算研究者的期望[7]。合理的情感模型不仅能够正确描述情感特征,而且应该适合于情感计算。传统的语音信号处理都是对中性语音进行建模[8],例如经典的LPC模型往往忽略了包含在语音信号中的情感因素。其实语音模型包含了情感因素,情感的变化会导致语音参数的明显变化,从而不利于语音识别等语音处理的相关应用。目前有针对性的适合于语音情感的建模方法的研究较少,甚至没有对含语音情感特征的发声模型方面进行专门研究。高斯混合模型[9]在语音识别、语音转换和模型研究领域应用广泛,是当今主流的模型研究方案。该模型可以对特征矢量进行软分类,克服矢量量化的不连续性,得到比较好的建模效果。为此,本文作者对语音情感特征的建模进行研究,建立基于高斯混合模型的情感LPC系数模型。

1 情感语音数据库

1.1 情感的类别

建立高质量的情感语音库是情感语音研究的基础,而情感的确定是建立情感语音数据库之前必须考虑的问题。研究表明,过细的情感分类并没有对人机交互和情感识别产生很重大的意义[10]。目前大多采用4~6种情感分类。国内许多学者将情感分为高兴、愤怒、惊奇、悲伤共4种进行相关研究,或者分为欢快、愤怒、恐惧、悲伤。这4种情感模型的优点是情感粒度大,容易区分辨别。为有效提高实验的准确程度,本文采用Russell情感空间[11]中的4种主要情感:愤怒、高兴、悲伤和中立。

1.2 数据库描述

语音产生的机理复杂。受包括语法句式、说话人情感以及个性特征等在内的众多因素的影响[12],为了突出情感特征参数受情感影响的程度,对所采用的中科院录制的情感语音库进行删选,在语句内容、长度、说话人等方面进行一定限制,有效避免了干扰因素的影响。录音人是一普通话标准的女性,采用wav文件格式保存,采样频率8 kHz。数据由144个时间为3 s的相同内容的汉语语音文件组成,高兴、愤怒、悲伤、中性这4种情感状态各36句,其中96个文件用于训练阶段,其余用于测试和结果分析。

2 基于高斯混合模型的情感LPC系数建模

2.1 建模的构架

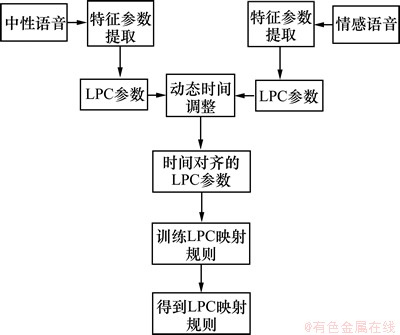

本文设计了关于情感LPC系数的基于GMM模型的建模方案。图1所示为本方案的基本流程,包括特征参数的提取、分析以及模型的训练。在训练阶段,中性语音和某一类型的情感语音分别经过预处理,提取出LPC特征参数矢量。由于两输入语音存在差异,需要对相应的特征参数进行时间对齐,采用动态时间规整(dynamic time warping)[13]的办法。在经过时间对齐后,将中性语音和情感语音的LPC特征矢量作为联合矢量对模型进行训练和参数估计,最终获得映射规则函数,完成对情感LPC参数的建模。

图1 建模流程图

Fig.1 Modeling flow chart

2.2 情感LPC系数的提取

实现情感LPC系数的提取的主要步骤如下。

(1) 预加重。语音信号经过高通滤波器H(z),其形式为

(1)

(1)

取滤波器的系数 ,经过预加重,使谱的包络平坦,以降低数值敏感度。

,经过预加重,使谱的包络平坦,以降低数值敏感度。

(2) 由于语音信号具有短时平稳性,对其进行分帧处理,加汉明窗。帧长与帧移的比值一般为1/2左右,考虑到可能进行FFT变换,帧长取256采样点,帧移128采样点。再用窗函数乘以分段的信号,从而形成加窗语音信号。

(3) 对于语音信号,一般包含无有用信息的静音段,本文采用双门限算法来检测语音的端点,利用过零率来检测清音,用短时能量来检测浊音,两者配合来实现可靠的端点检测。

(4) 采用杜宾算法[14]提取语音库中情感语句的12阶LPC系数,选择滤波器的阶数p=12可以对绝大多数语音信号的声道模型取得足够近似的逼近,得到4种情感的LPC系数的谱包络,如图2所示。

2.3 模型的训练

在获得训练语音帧的LPC系数矢量集后,利用这些特征矢量训练一个高斯混合模型拟合其概率分布。模型训练的本质是利用训练参数矢量集估计GMM模型的参数,包括每个单高斯函数的均值μi、协方差矩阵 和权重ωi,模型的完整参数集

和权重ωi,模型的完整参数集 可表示为(其中,M为模型的阶数)

可表示为(其中,M为模型的阶数)

,i=1, 2, …, M (2)

,i=1, 2, …, M (2)

对于GMM模型的参数训练,采取从训练数据中随机选取10个矢量作为模型的初始化参数,采用EM算法不断地迭代来调整参数集λ,从而使确定的GMM模型能最佳地描述给定的语音训练数据的概率分布。

设一组给定的特征矢量序列为X={Xt,t=1, 2, …, T},则GMM的似然度P可以表示为

(3)

(3)

训练的目的就是找到一组参数λ,使似然度最大,即

(4)

(4)

从λ的初值开始,采用EM算法估计出下一个新的参数 ,使得新的模型参数下的似然度逐步增大。新的模型参数再作为新的初始模型参数进行训练,这样迭代运算直至模型收敛为止。EM算法的迭代过程(第n+l步)表示如下。

,使得新的模型参数下的似然度逐步增大。新的模型参数再作为新的初始模型参数进行训练,这样迭代运算直至模型收敛为止。EM算法的迭代过程(第n+l步)表示如下。

混合权值P(ωi)的重估迭代公式为

(5)

(5)

均值μi的重估公式为

(6)

(6)

图2 各情感下的LPC分析谱

Fig.2 LPC spectrum in different emotions

方差 的重估公式为

的重估公式为

(7)

(7)

式(5)~(7)中的后验概率 由下式表示:

由下式表示:

(8)

(8)

其中: 为单个子分布的联合高斯分布,

为单个子分布的联合高斯分布,

(9)

(9)

式(5),(6)和(7)同时执行了求期望值(E步)和最大化(M步)。对上述公式重复迭代,就是对EM算法中E步和M步的重复迭代,直至找到似然函数的极大值 为止。

2.4 映射规则

基于GMM模型获得情感语音和中性语音的LPC系数之间的映射规则,就是根据情感语音的LPC特征矢量Xt、中性语音LPC特征矢量Yt,训练得到相应的映射函数F,使式(10)中的 最小。

最小。

(10)

(10)

首先假设F是分段线性的,且具有如下形式:

(11)

(11)

其中 是条件概率,如下式所示:

是条件概率,如下式所示:

(12)

(12)

式(11)中的未知参数vi和Гi是通过对式(10)运用MMSE准则获得。

假定中性和情感语音的相应的LPC参数矢量分别为Xt和Yt,对于该特征矢量具备联合高斯分布的情况下,映射函数具有以下的最优形式:

(13)

(13)

式中: ,

, 和

和 为未知参数,它们可由通过联合矢量Zt=[XtTYtT]T训练的GMM模型得到。其中新矢量Zt的GMM模型参数为:

为未知参数,它们可由通过联合矢量Zt=[XtTYtT]T训练的GMM模型得到。其中新矢量Zt的GMM模型参数为:

(14)

(14)

(15)

(15)

可以从式(14)和(15)的矩阵中直接提取映射函数所需要的参数,因此,训练过程就是通过对联合矢量Zt进行GMM模型的训练,从而得到映射函数所需要的参数,整理得到映射函数参数集为

(16)

(16)

3 实验结果分析

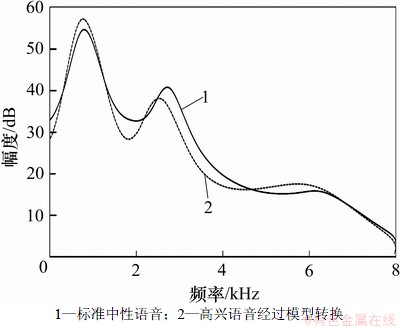

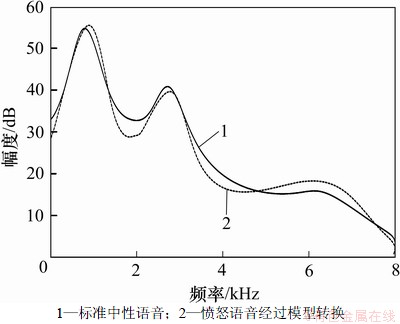

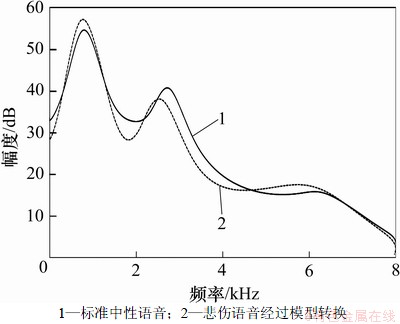

为了检验高兴、愤怒、悲伤这3类情感建模的效果,进行了如下3个实验。分别把提取到的高兴(实验1)、愤怒(实验2)、悲伤(实验3)这3类LPC系数经过对应模型映射,将得到的LPC谱包络与标准中性语音的LPC谱包络进行对比。

高兴-中性的情感转换实验结果见图3,愤怒-中性的情感转换实验结果见图4,悲伤-中性的情感转换实验结果见图5。

从图3~5可见:由高兴到中性情感模型转换得到的LPC频谱是最接近的(图3);后两者(图4和图5)虽然有差距,但在轮廓上大致匹配,证明这3个情感GMM模型反映了对应情感的LPC情感特征,得到的转换规则有效。为了更客观地观察实验结果,以下采用客观评估的方法。

图3 实验1的LPC谱比较

Fig.3 Comparison of LPC spectrum in experiment 1

图4 实验2的LPC谱比较

Fig.4 Comparison of LPC spectrum in experiment 2

图5 实验3的LPC谱比较

Fig.5 Comparison of LPC spectrum in experiment 3

板仓-斋田谱失真测度又称匹配误差测度(error matching measure)[15],本文根据该准则来衡量2个参数之间的距离,该准则定义为

(17)

(17)

其中:yt为标准中性语音提取的LPC参数; 为通过模型进行映射后的LPC参数;

为通过模型进行映射后的LPC参数; 为yt和

为yt和 两者之间的距离。

两者之间的距离。

本文采用Itakura Saito(IS)距离准则来判断2个LPC谱的相似性,并定义IS距离下降率ISratio来衡量两者之间接近的性能:

(18)

(18)

其中:X和Y为对齐的LPC参数对; 为通过模型映射之后的LPC参数;d(Y, X)为情感语音和标准中性语音两参数对之间的平均IS距离;ISratio为标准中性语音和通过模型映射之后的LPC参数之间的平均IS距离,其值越大,表示模型效果越好,也就是由情感语音映射转换所得的中性参数更接近标准的中性语音。

为通过模型映射之后的LPC参数;d(Y, X)为情感语音和标准中性语音两参数对之间的平均IS距离;ISratio为标准中性语音和通过模型映射之后的LPC参数之间的平均IS距离,其值越大,表示模型效果越好,也就是由情感语音映射转换所得的中性参数更接近标准的中性语音。

愤怒、高兴、悲伤这3种情感GMM模型下计算得到的ISratio分别为62.3%,70.5%和59.5%,可见高兴状态下的匹配度最高,且愤怒和悲伤情感状态的取值也趋近60.0%,具备了比较好的匹配度。这表明由GMM模型建立的情感LPC映射函数在一定程度上较好地表征了其特征。

4 结论

(1) 通过研究情感特征与LPC系数之间的映射关系,提出建立LPC系数情感模型的新方法,并得到基于高斯混合模型的高兴、愤怒、悲伤共3种情感模型。

(2) 建立的情感模型有效表征了不同情感对LPC系数的影响。该方法为情感语音合成、识别等研究提供了新思路。

参考文献:

[1] Su Z, Wang Z. An approach to affective-tone modeling for Mandarin[C]// Tao J H, Tan T N, Picard R W. Affective Computing and Intelligent Interaction. Beijing, 2005: 390-396.

[2] Hao E H K, Kyung H H. Emotion interactive robot focus on speaker independently emotion recognition[C]// IEEE. ASME International Conference on Advanced Intelligent Mechatronic. Zurich, Switzerland, 2007: 1-6.

[3] Burkhart F. Verification of acoustical correlates of emotional speech using formant synthesis[C]// Proceedings of the ISCA Workshop on Speech and Emotion. Northern Ireland, 2000: 151-156.

[4] Moriyama T, Saito H, Ozawa S. Evaluation of relation between emotional concepts and emotional parameters in speech[J]. Systems and Computers in Japan, 2001, 32(4): 59-68.

[5] Lieberman P, Michaels S B. Some aspects of fundamental frequency and envelop amplitude as related to the emotional content of speech[J]. Journal of the Acoustical Society of America, 1999, 8(34): 922-927.

[6] Abelin A, Allwood J. Cross linguistic interpretation of emotional prosody[C]// ISCA Workshop on Speech and Emotion. New Orleans, America, 2000: 110-113.

[7] Vine D S G, Sahandi R. Synthesis of emotional speech using RP-PSOLA[C]// IEEE Seminar State of the Art in Speech Synthesis Proceedings. London, 2000: 8/1-8/6.

[8] Murray I R. Emotion in concatenated speech[C]// IEEE Seminar State of the Arts in Speech Synthesis Proceedings. London, 2000: 7/1-7/8.

[9] 张鹏. 基于高斯混合模型的语音转换方法研究[D]. 南京: 南京邮电大学通信与信息工程学院, 2009: 58-65.

ZHANG Peng. A study of voice conversion method based on GMM[D]. Nanjing: Nanjing University of Posts and Telecommunications. School of Communication and Information Engineering, 2009: 58-65.

[10] 张立华, 杨莹春. 情感语音变化规律的特征分析[J]. 清华大学学报: 自然科学版, 2008, 48(S1): 652-657.

ZHANG Lihua, YANG Yingchun. Analysis of emotional speech’s changing rules[J]. Journal of Tsinghua University: Nature Scientific Edition, 2008, 48(S1): 652-657.

[11] GAO Hui, CHEN Shanguang. Emotion classification of infant voice based on features derived from teenager energy operator[C]// IEEE Congress on Image and Signal Processing. Sanya, Hainan, China, 2008: 333-337.

[12] Scherer K R, Banziger T. Emotional expression in prosody: A review and an agenda for future research[C]// Speech Prosody. IEEE Workshop on Automatic Speech Recognition and Understanding. Nara, Japan, 2004: 359-366.

[13] 范新伟, 申瑞民, 杜彦蕊. 用LPC及DTW进行语音模式比较的设计与实现[J]. 计算机工程, 2004, 30(1): 126-128.

FAN Xinwei, SHEN Ruimin, DU Yanrui. Design and implementation of speech pattern comparison by using LPC & DTW method[J]. Computer Engineering, 2004, 30(1): 126-128.

[14] 胡航. 语音信号处理[M]. 哈尔滨: 哈尔滨工业大学出版社, 2005: 86-98.

HU Hang. Speech signal processing[M]. Harbin: Harbin Institute of Technology Press, 2005: 86-98.

[15] Kleinginna P R, Kleinginna A M. A categorized list of emotion definitions with suggestions for a consensual definition[J]. Motivation and Emotion, 2006, 5(4): 345-379.

(编辑 陈灿华)

收稿日期:2012-09-12;修回日期:2012-11-22

基金项目:国家自然科学基金资助项目(61074001);中南大学研究生科研创新项目(2011ssxt219)

通信作者:陈明义(1964-),男,湖南长沙人,博士,教授,从事信号处理、语音编码、语音识别、语音合成、语音质量客观评估等研究;电话:0731-88836965;E-mail: myccsu@163.com

摘要:针对当前缺乏语音情感特征的发声模型研究的具体现状,通过探索情感特征与线性预测编码(LPC)系数之间的映射关系,提出建立LPC系数情感模型的新方法。该方法在中科院情感语音库的基础上分别建立高兴、愤怒、悲伤及中性4种情感数据库;通过采用不同情感语音的LPC特征矢量,结合动态时间规整技术(DTW)、期望最大化算法(EM)和最小均方误差准则(MMSE)对高斯混合模型进行训练和参数估计,最终获得高兴、愤怒、悲伤这3种情感对中性语音的LPC系数映射规则函数,完成对情感LPC系数的建模。研究结果表明:建立的情感模型有效表征了不同情感对LPC系数的影响;该方法为情感语音合成、识别等研究提供了新思路。